Google浏览器网页内容抓取插件实用指南

1. 插件选择与安装

- Web Scraper:适合无编程经验的用户,支持可视化选取网页元素并导出CSV/JSON格式数据。安装后点击插件图标→创建新站点地图→输入名称与目标URL→通过“选择范围”框选页面区域→添加二级选择器提取字段(如标题、作者)→点击“Scrape”启动抓取。若需处理分页数据,可设置“滚动加载”选项。

- XPath Helper:技术用户可用,直接生成XPath路径。打开目标网页→点击插件图标→点击所需元素→复制XPath表达式→配合脚本(如Python的`lxml`库)批量提取数据。

- Selenium IDE:适用于需要模拟用户操作的场景。录制在网页上的点击、输入等操作→在生成的脚本中插入数据提取代码(如`document.querySelector(".title").innerText`)→导出为Python或JavaScript脚本。

2. 基础抓取操作

- 在Web Scraper中,若仅需快速抓取单一页面,可直接拖动鼠标选中目标区域→保存选择器→点击“Start Scraping”。对于动态加载内容(如无限滚动页面),需启用“滚动加载”选项→设置延迟时间→手动下拉页面触发加载。

- 使用Octoparse时,创建采集任务→输入目标URL→选择“智能模式”自动识别字段→预览数据→启动本地采集。若网站有反爬虫机制,可切换至“高级模式”自定义请求头(如`User-Agent`)。

3. 高级配置技巧

- 在Web Scraper的站点地图设置中,取消勾选“Multiple”可精准定位单个元素→组合多个选择器提取不同字段(如同时抓取标题和发布时间)。若数据混乱,可添加“排序规则”(如按阅读数降序)→导出CSV后直接用Excel筛选。

- 对于需要定时抓取的任务,可在Chrome扩展页面(`chrome://extensions/`)找到插件→点击“详情”→启用“定时任务”→设置频率(如每小时一次)→选择“发送至邮箱”或连接云存储(如Google Drive)。

4. 数据导出与清理

- Web Scraper支持导出为CSV或JSON格式。在输出面板中,勾选“合并空格”避免文本断行→设置列分隔符为逗号→点击“Export Data”保存文件。若数据含特殊字符,可选择“引用包裹”防止格式错误。

- 使用Selenium IDE时,在脚本中添加`console.log(data)`查看提取结果→右键保存脚本为`.js`文件→通过Node.js运行脚本并重定向输出到文件(如`node script.js > output.txt`)。

5. 应对反爬策略

- 若目标网站检测到插件,可尝试修改插件设置:在Web Scraper中更改“用户代理”(如伪装成移动设备)→限制抓取频率(如每次间隔5秒)→禁用“并行线程”减少请求压力。若仍失败,需手动添加Cookie或使用代理IP。

- 对于需要登录的网站,在Web Scraper中添加“登录步骤”→输入账号密码→保存会话Cookie→后续抓取任务自动携带凭证。注意定期更新Cookie以防过期。

请根据实际情况选择适合的操作方式,并定期备份重要数据以防丢失。

如何在Chrome浏览器中查看和修复页面的SEO问题

通过Chrome浏览器查看和修复网页中的SEO问题,提升页面搜索引擎排名和用户体验。

QQ浏览器提示必要的系统组件未能正常运行

在我们使用QQ浏览器浏览网页的时候,偶尔会出现“必要的系统组件未能正常运行,请修复AdobeFlashPlayer”的提示。

谷歌浏览器是否支持访问密度统计与热点聚合报告

谷歌浏览器支持访问密度统计与热点聚合报告功能,能够对网页内容的访问密度进行统计并生成热点聚合报告。此功能帮助开发者分析用户访问行为,优化内容布局,提升网页的访问效率和用户体验。

如何在Windows上启用Chrome的沙盒模式

本页为大家详细介绍关于如何在Windows上启用Chrome的沙盒模式的具体教程并附有图文。

uc浏览器公司介绍及安装教程

用过UC浏览器小伙伴一定有很多吧,这款浏览器被大家所熟知的原因,是因为UC浏览器强大的资讯服务,使得越来越多的人慕名而来下载了这款浏览器。各式各样的电脑版浏览器层出不穷,它仍然占有自己的一席之地。

谷歌浏览器快捷键自定义及效率提升实用教程

谷歌浏览器支持快捷键自定义,教程讲解常用快捷键及个性化设置,帮助用户提升操作效率和使用体验。

win10怎么下载谷歌浏览器_下载谷歌浏览器方法

本网站提供谷歌官网正版谷歌浏览器【google chrome】全版本下载安装包,软件经过安全检测,无捆绑,无广告,操作简单方便。

如何在 Kali Linux 上安装 Google Chrome 浏览器?

在 Kali 上安装 Google Chrome 非常简单,但并不像你想象的那么简单。由于 Chrome 是一个封闭源代码的 Web 浏览器,因此无法从默认软件包存储库安装它。不用担心,您将通过几个简短的步骤了解如何安装它。

google浏览器下载失败怎么办

相信大家或多或少的都听过有人说哪个浏览器最好用——谷歌浏览器,谷歌浏览器一款可让您更快速、设计超级简洁,使用起来更加方便的网页浏览器。

如何在电脑上下载windos版谷歌浏览器?<下载方法>

Google Chrome是广泛应用于各种设备和操作系统的浏览器。最好的是,它适用于所有操作系统。所以,无论你使用macOS、WindowsOS还是Linux,你都可以使用Chrome浏览器。你只需进入Chrome官方网站,点击下载Chrome即可在你的电脑上下载操作系统的最新更新版本。现在,你需要安装下载的文件并开始使用Chrome。

谷歌浏览器更新提示0x80040902错误代码怎么解决?

Google Chrome是谷歌(Google)公司研发的一个网页浏览器,该浏览器提供简单高效率的界面。其支持多标签浏览,方便用户根据需求随时打开已打开的页面进行浏览。

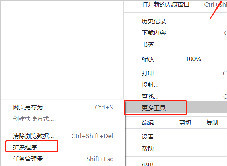

谷歌浏览器任务管理器怎么打开

本篇文章中小编给大家带来开启chrome浏览器任务管理器的详细操作流程,希望能够帮助大家解决问题。

如何在 Chrome 中调整标签的音量?

Chrome 有一些用于控制标签的漂亮功能。它错过的一项功能是调整单个标签的音量。

如何降低 iOS 版 Chrome 中的数据使用量?

如果您的数据计划有限,监控iPhone数据使用情况可能是日常生活的重要组成部分。在浏览互联网时尤其如此,因为 来回飞来飞去的千字节和兆字节的数量迅速增加。为了让事情变得更简单,谷歌浏览器提供了带宽管理功能,允许您设置浏览器何时预加载网页。预加载网页可加快您的浏览器体验,并使用数据。

如何使用 Google 的实验性“标志”增强 Chrome?

希望启用更好的浏览?加速 Chrome?Google Chrome 允许您启用称为标志的实验性功能。以下是 10 个可以尝试的最佳 Google Chrome 标志。

怎么关闭谷歌浏览器的自动更新_谷歌浏览器自动更新关闭方法

总有人更喜欢旧版,你知道如何禁用谷歌浏览器的自动更新吗,快来和小编学学看吧!

谷歌浏览器设置夜间模式_谷歌浏览器夜间模式怎么开

有些人在夜间办公时觉得谷歌浏览器的亮色主题非常晃眼,那该如何使用谷歌浏览器的夜间模式呢,小编这就教你!

谷歌浏览器谷歌应用商店打不开怎么办?下载商店插件办法!

你有没有在使用谷歌浏览器的时候遇到各种问题呢,你知道谷歌浏览器谷歌应用商店打不开是怎么回事呢?来了解谷歌浏览器谷歌应用商店打不开的解决方法,大家可以学习一下。